Данная видеокарта будет основным элементом будущего суперкомпьютера, а сама система будет в полтора раза лучше мощнейшего суперкомпьютера США. Также Nvidia анонсировала множество корпоративных продуктов, ориентированных на ИИ, на своей ежегодной конференции GTC.

Новые продукты включают в себя:

- детали новой кремниевой архитектуры Hopper;

- первый GPU для центров обработки данных, созданный с использованием этой архитектуры, H100; новый «суперчип» Grace CPU;

- неясные планы по созданию того, что, по утверждению компании, станет самым быстрым в мире суперкомпьютером с искусственным интеллектом под названием Eos.

Nvidia извлекла огромную выгоду из бума искусственного интеллекта в последнее десятилетие, поскольку ее графические процессоры идеально подходят для популярных методов глубокого обучения с интенсивным использованием данных. По словам Nvidia, поскольку спрос сектора ИИ на вычисления данных растет, она хочет обеспечить подходящие под этот спрос вычислительные мощности.

В частности, компания подчеркнула популярность системы машинного обучения, известной как Transformer. Этот метод оказался невероятно плодотворным, поскольку он поддерживает все, от языковых моделей, таких как GPT-3 OpenAI, до медицинских систем, таких как AlphaFold от DeepMind. Такие модели выросли в размерах в геометрической прогрессии за несколько лет. Например, когда OpenAI запустил GPT-2 в 2019 году, он содержал 1,5 миллиарда параметров (или соединений). Когда всего два года спустя Google обучил аналогичную модель, она использовала 1,6 триллиона параметров (больше в тысячу раз!).

«Обучение этих гигантских моделей по-прежнему занимает месяцы, — сказал на брифинге для прессы старший директор Nvidia по управлению продуктами Пареш Харья. «Итак, вы запускаете процесс и ждете полтора месяца, чтобы посмотреть, что произойдет. Основная проблема сокращения времени обучения заключается в том, что прирост производительности начинает снижаться по мере увеличения количества графических процессоров в центре обработки данных».

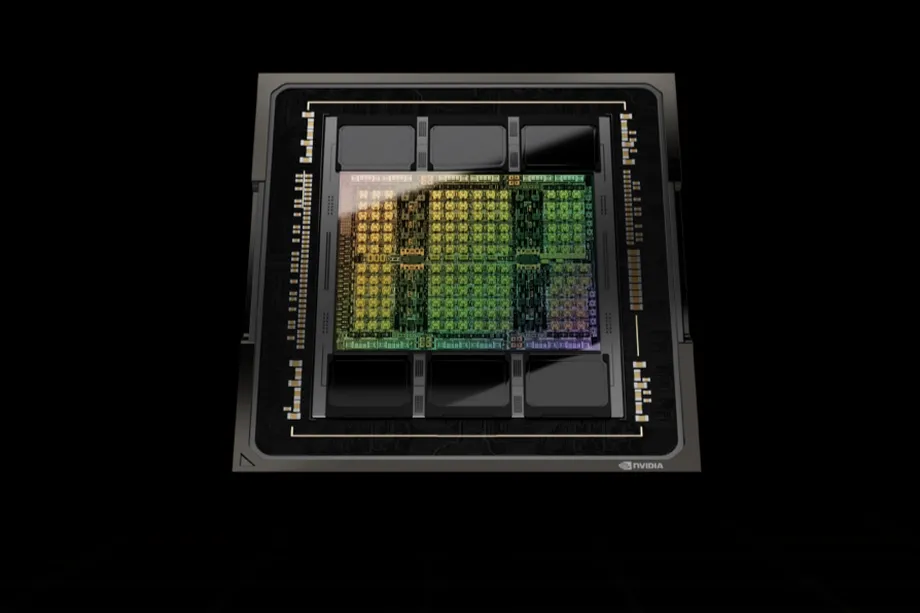

Nvidia заявляет, что ее новая архитектура Hopper поможет решить эти проблемы. Архитектура, названная в честь ученого-новатора и контр-адмирала ВМС США Грейса Хоппера, предназначена для ускорения обучения моделей Transformer на графических процессорах H100 в шесть раз по сравнению с чипами предыдущего поколения, а новое NVlink четвертого поколения может подключать до 256 Графические процессоры H100 с пропускной способностью в девять раз выше, чем у предыдущего поколения.

Сам графический процессор H100 содержит 80 миллиардов транзисторов и является первым графическим процессором, поддерживающим PCle Gen5 и использующим HBM3, что обеспечивает пропускную способность памяти 3 ТБ/с. Nvidia заявляет, что графический процессор H100 в три раза быстрее, чем его A100 предыдущего поколения при вычислениях FP16, FP32 и FP64, и в шесть раз быстрее при 8-битных вычислениях с плавающей запятой.

«Для обучения гигантских моделей трансформеров, H100 предлагает в девять раз более высокую производительность, тренируясь за несколько дней, а раньше на это уходили недели», — сказал Харья.

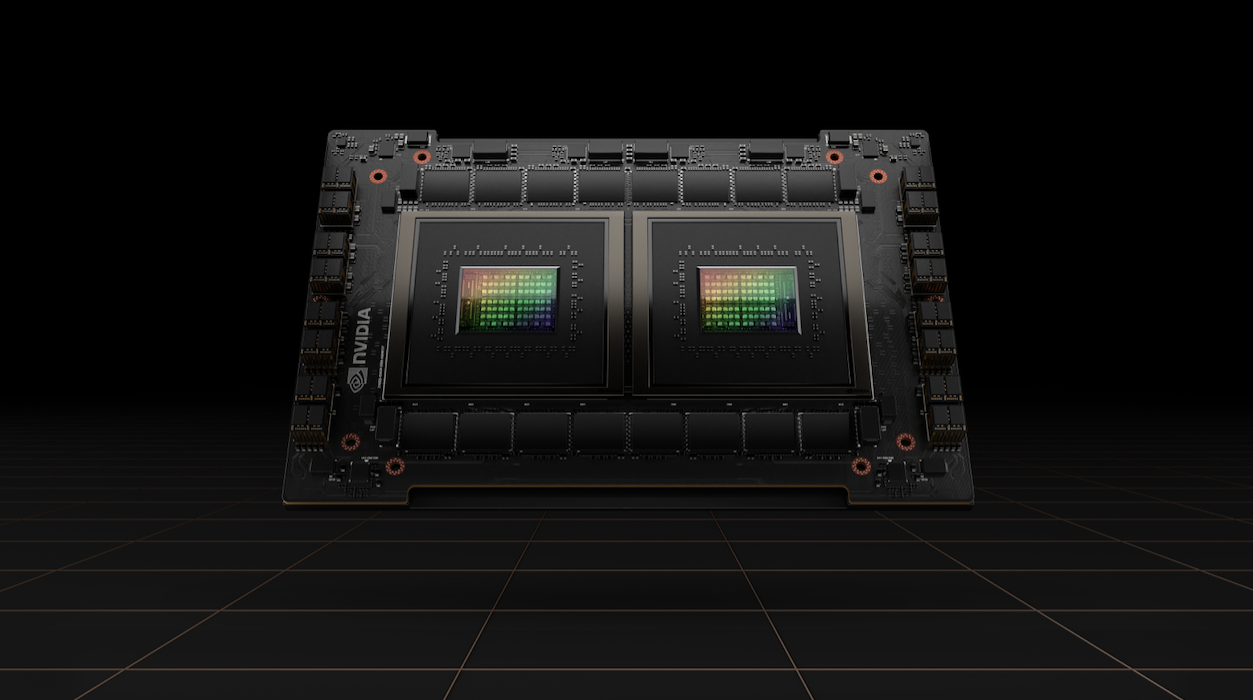

Компания также анонсировала новый процессор для центров обработки данных, Grace CPU Superchip, который состоит из двух процессоров, подключенных напрямую через новый NVLink-C2C с малой задержкой. Чип предназначен для «обслуживания гигантских приложений для высокопроизводительных вычислений и искусственного интеллекта» вместе с новыми графическими процессорами на базе Hopper и может использоваться только для систем с процессором или серверов с ускорением на графическом процессоре. Он имеет 144 ядра Arm и пропускную способность памяти 1 ТБ/с.

Помимо новостей об оборудовании и инфраструктуре, Nvidia также объявила об обновлениях своих различных программных сервисов искусственного интеллекта, включая Maxine (SDK (комплект для разработки программного обеспечения для улучшения звука и видео, предназначенный для поддержки таких вещей, как виртуальные аватары) и Riva (SDK, используемый как для распознавания речи, и преобразование текста в речь).

Компания также тизерила, что строит новый суперкомпьютер с искусственным интеллектом, который, по ее утверждению, будет самым быстрым в мире при запуске. Суперкомпьютер под названием Eos будет построен с использованием архитектуры Hopper и будет содержать около 4600 графических процессоров H100, обеспечивающих 18,4 экзафлопс «производительности ИИ». Система будет использоваться только для внутренних исследований Nvidia, и компания заявила, что она будет подключена к сети через несколько месяцев.

За последние несколько лет ряд компаний, проявляющих большой интерес к ИИ, построили или объявили о создании собственных «суперкомпьютеров ИИ» для внутренних исследований, в том числе Microsoft, Tesla и Meta (запрещенная в России организация). Эти системы нельзя напрямую сравнивать с обычными суперкомпьютерами, поскольку они работают с более низким уровнем точности, что позволило ряду фирм быстро обойти друг друга, объявив себя самыми быстрыми в мире.

Однако во время своего основного доклада генеральный директор Nvidia Дженсен Хуанг сказал, что Eos при выполнении традиционных задач суперкомпьютера будет обрабатывать 275 петафлопс — в 1,4 раза быстрее, чем «самый быстрый научный компьютер в США» (Summit).

«Мы ожидаем, что Eos станет самым быстрым компьютером с искусственным интеллектом в мире», — сказал Хуанг. «Eos станет образцом самой передовой инфраструктуры искусственного интеллекта для наших OEM-производителей и облачных партнеров».Подписывайтесь на T4S.TECH в Telegram. Публикуем новости, обзоры и забавные факты о технологиях.