Meta* представила инструмент искусственного интеллекта ImageBind с открытым исходным кодом, который предсказывает связи между данными, подобные тому, как люди воспринимают или представляют себе окружающую среду.

В то время как генераторы изображений, такие как Midjourney, Stable Diffusion и DALL-E 2, объединяют слова с изображениями, позволяя создавать визуальные сцены на основе только текстового описания, ImageBind использует более широкую сеть. Он может связывать текст, изображения/видео, аудио, 3D-измерения (такие как глубина), данные о температуре и данные о движении (из инерциальных единиц измерения) — и делает это без необходимости предварительного обучения каждой возможности.

Это ранняя стадия фреймворка, который в конечном итоге может генерировать сложные среды из таких простых входных данных, как текстовая подсказка, изображение или аудиозапись (или некоторая комбинация этих трех).

Вы можете рассматривать ImageBind как приближение машинного обучения к обучению человека. Например, если вы стоите в стимулирующей среде, такой как оживленная городская улица, ваш мозг (в основном бессознательно) поглощает образы, звуки и другие сенсорные ощущения, чтобы вывести информацию о проезжающих автомобилях и пешеходах, высоких зданиях, погоде и многом другом.

Люди и другие живые существа эволюционировали, чтобы обрабатывать эти данные для нашего генетического преимущества: выживания и передачи нашей ДНК (чем лучше вы осведомлены о своем окружении, тем больше вы можете избежать опасности и адаптироваться к окружающей среде для лучшего выживания и процветания). По мере того, как компьютеры приближаются к имитации мультисенсорных связей животных, они могут использовать эти связи для создания полностью реализованных сцены, основанные только на ограниченных фрагментах данных.

Таким образом, хотя вы можете использовать Midjourney, чтобы показать «бассет-хаунда в костюме Гэндальфа, балансирующего на пляжном мяче» и получить относительно реалистичную фотографию этой причудливой сцены, мультимодальный инструмент искусственного интеллекта, такой как ImageBind, может в конечном итоге создать видео собаки с соответствующими звука, включая детализированную пригородную гостиную, температуру в комнате и точное местонахождение собаки и кого-либо еще в сцене.

«[ImageBind] предоставляет отличительные возможности для создания анимации из статических изображений путем объединения их со звуковыми подсказками», — заявили сегодня исследователи Meta* в блоге, ориентированном на разработчиков.

«Например, создатель может соединить изображение с будильником и криком петуха, а также использовать звуковую подсказку с криком петуха, чтобы сегментировать петуха, или звук будильника, чтобы сегментировать часы, и анимировать их в видеоряд».

Что еще можно сделать с этой новой игрушкой, это ясно указывает на одну из основных амбиций Meta*: виртуальная реальность, смешанная реальность и метавселенная. Например, представьте себе будущую гарнитуру, которая может на лету создавать полностью реализованные 3D-сцены (со звуком, движением и т. д.). Или разработчики VR игр, возможно, могли бы в конечном итоге использовать его, чтобы упростить процесс проектирования.

Точно так же создатели контента могут создавать иммерсивные видеоролики с реалистичными звуковыми ландшафтами и движением, основываясь только на тексте, изображении или аудиовходе. Также легко представить себе такой инструмент, как ImageBind, открывающий новые двери в пространстве специальных возможностей, генерирующий мультимедийные описания в реальном времени, чтобы помочь людям с нарушениями зрения или слуха лучше воспринимать свое непосредственное окружение.

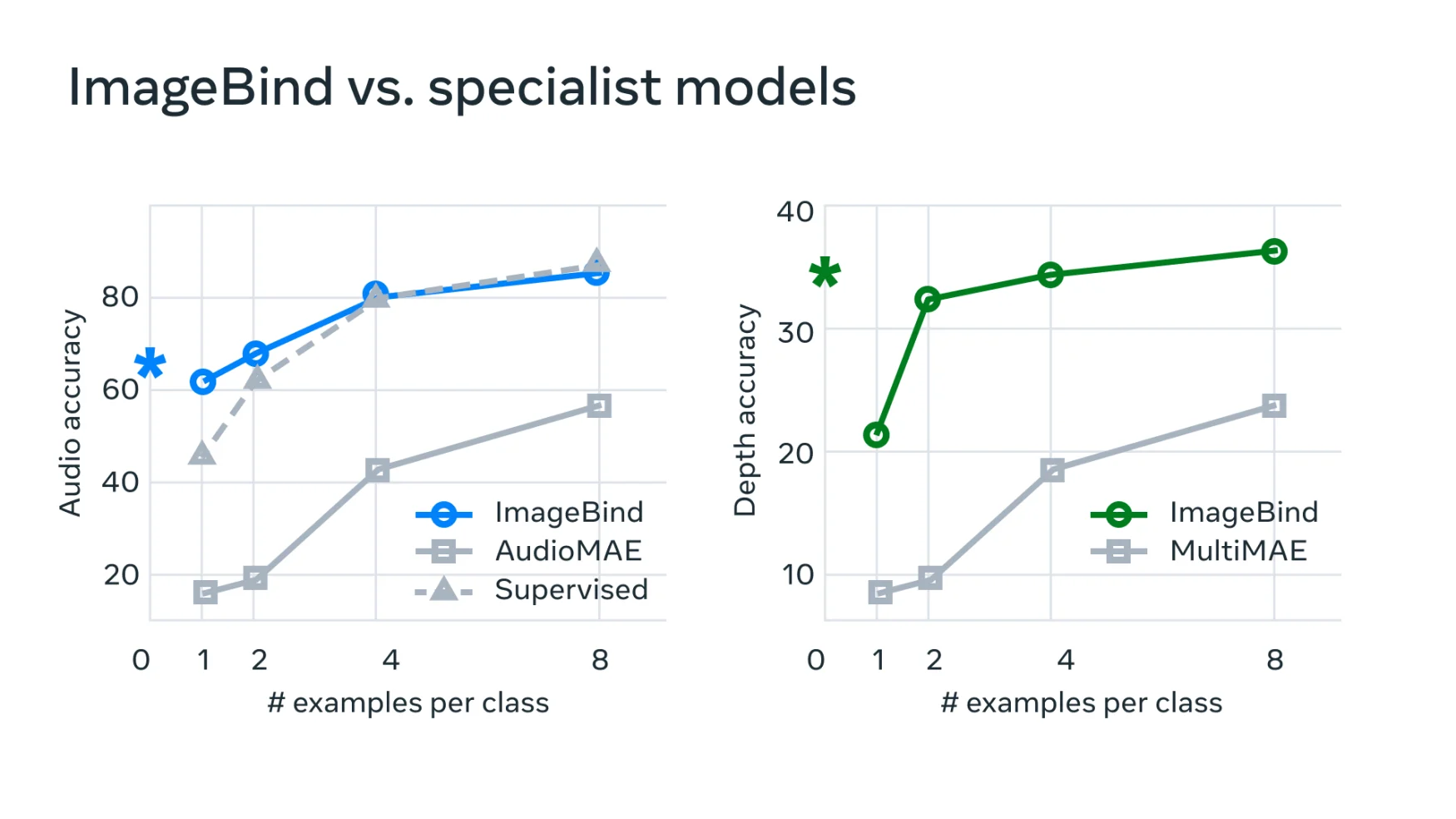

«В типичных системах ИИ существует определенное векторное описание (то есть векторы чисел, которые могут представлять данные и их отношения в машинном обучении) для каждой соответствующей модальности», — сказал Meta*.

«ImageBind показывает, что можно создать совместное векторное пространство в нескольких модальностях без необходимости тренировки на данных с каждой комбинацией модальностей. Это важно, потому что исследователи не могут создавать наборы данных с образцами, которые содержат, например, аудиоданные и тепловые данные с оживленной городской улицы или данные о глубине и текстовое описание приморского утеса».

Meta* считает, что технология в конечном итоге выходит за рамки ее нынешних шести «чувств», так сказать.

«Хотя в нашем текущем исследовании мы изучили шесть модальностей, мы считаем, что введение новых модальностей, которые связывают как можно больше чувств, таких как осязание, речь, обоняние и сигналы фМРТ мозга, позволит создать более богатые модели искусственного интеллекта, ориентированные на человека».

Разработчики, заинтересованные в изучении этой новой песочницы, могут начать с изучения открытого исходного кода Meta.

*Meta – запрещенная на территории России организация.

Подписывайтесь на T4S.TECH в Telegram. Публикуем новости, обзоры и забавные факты о технологиях.