Профессор Университета Торонто Джеффри Хинтон, которого часто называют «крестным отцом ИИ» за его новаторские исследования в области нейронных сетей, недавно стал неофициальным наблюдателем отрасли. Этой весной он ушел из Google, чтобы более свободно критиковать область, в которой он стал первопроходцем.

Он рассматривал недавний всплеск генеративных ИИ, таких как ChatGPT и Bing Chat, как признаки неконтролируемого и потенциально опасного ускорения разработки. Тем временем Google, по-видимому, отказывался от своей прежней сдержанности, преследуя конкурентов с помощью таких продуктов, как чат-бот Bard.

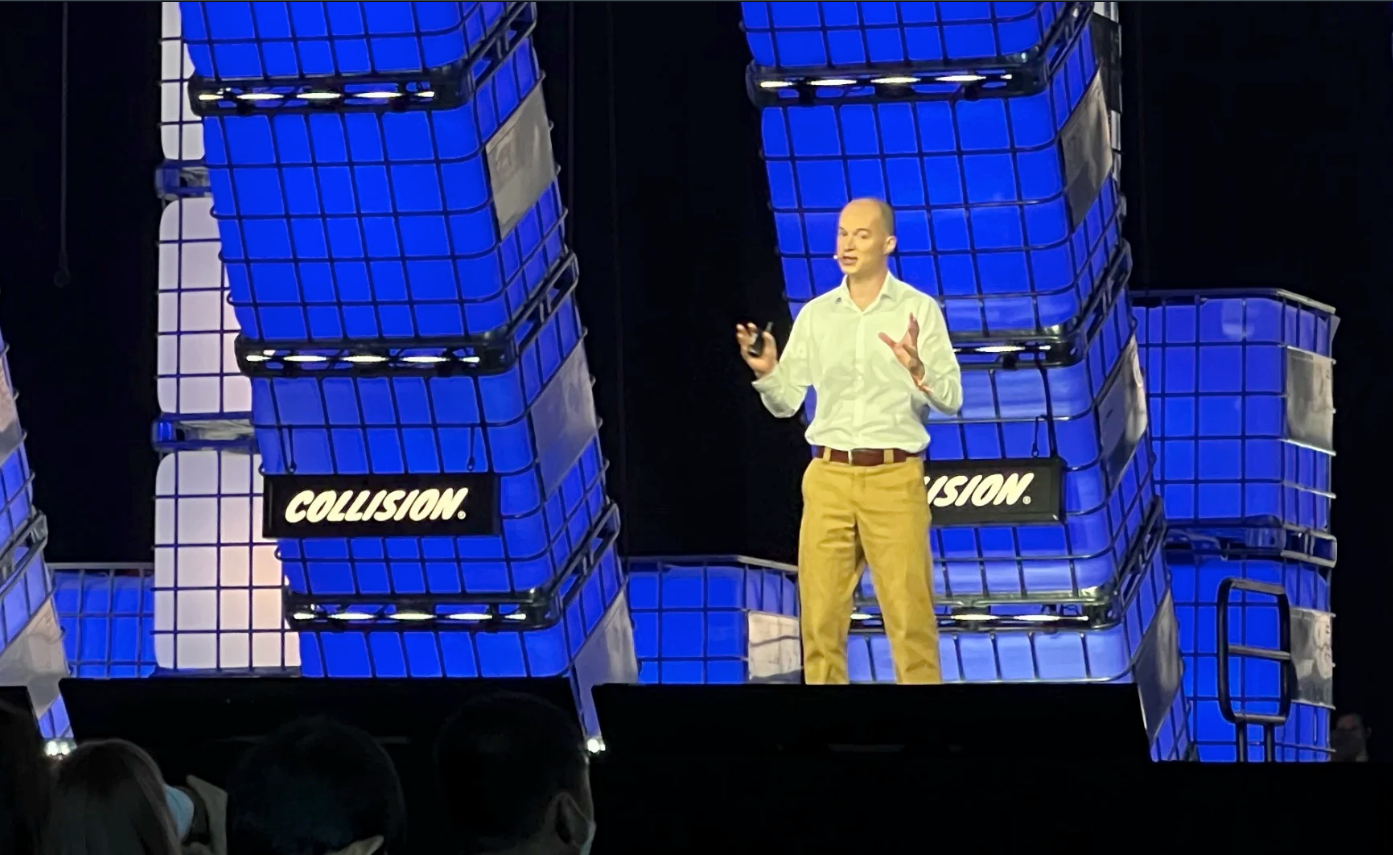

На конференции Collision на этой неделе в Торонто Хинтон расширил свои опасения. В то время как компании рекламировали ИИ как решение всего, от заключения договора аренды до доставки товаров, Хинтон бил тревогу. Он не уверен, что «хороший» ИИ одержит победу над «плохим», и считает, что этичное внедрение ИИ может дорого обойтись.

Угроза человечеству

Хинтон утверждал, что ИИ хорош настолько, насколько хороши люди, которые его создали, и что плохая технология все еще может победить.

«Я не уверен, что хороший ИИ, который пытается остановить плохое, может получить контроль», — пояснил он.

Например, по его словам, может быть трудно остановить военно-промышленный комплекс от производства боевых роботов — компании и армии могут «любить» войны, где жертвами являются машины, которые можно легко заменить. И хотя Хинтон считает, что большие языковые модели (обученный ИИ, создающий человекоподобный текст, например GPT-4 от OpenAI) могут привести к значительному повышению производительности, он обеспокоен тем, что правящий класс может просто использовать это для собственного обогащения, расширяя и без того большой разрыв в богатстве. Это «сделает богатых еще богаче, а бедных — еще беднее», — сказал Хинтон.

Хинтон также повторил свое широко разрекламированное мнение о том, что ИИ может представлять экзистенциальный риск для человечества. Если искусственный интеллект станет умнее людей, нет никакой гарантии, что люди останутся у власти. «У нас будут проблемы», если ИИ решит, что контроль необходим для достижения его целей, сказал Хинтон. Для него угрозы — это «не просто научная фантастика», к ним нужно относиться серьезно. Он опасается, что общество станет обуздать роботов-убийц только после того, как увидит, «насколько они ужасны».

Хинтон добавил, что существует множество существующих проблем. Он утверждает, что предвзятость и дискриминация остаются проблемами, поскольку искаженные данные обучения ИИ могут привести к несправедливым результатам. Алгоритмы также создают эхо-камеры (закрытые сообщества определенных взглядов), которые усиливают дезинформацию и проблемы с психическим здоровьем. Хинтон также беспокоится о том, что искусственный интеллект распространяет дезинформацию за пределы этих «камер». Он не уверен, можно ли обнаружить каждое ложное утверждение, хотя «важно помечать все фейки как фейки».

Это не означает, что Хинтон отчаялся в воздействии ИИ, хотя он и предупреждает, что использование технологии может дорого обойтись. Людям, возможно, придется провести «эмпирическую работу», чтобы понять, как ИИ может пойти не так, и не допустить, чтобы он получил контроль. Он добавил, что исправить предубеждения еще «возможно». Искусственный интеллект с большой языковой моделью мог бы положить конец эхо-камерам, но Хинтон считает изменения в политике компании особенно важными.

Профессор не жалел слов, отвечая на вопросы о людях, потерявших работу из-за автоматизации. Он считает, что «социализм» необходим для решения проблемы неравенства, и что люди могут застраховаться от безработицы, выбрав профессию, которая может меняться со временем, например, сантехника (и нет, он не пошутил). По сути, обществу, возможно, придется внести серьезные изменения, чтобы адаптироваться к ИИ.

Промышленность сохраняет оптимизм

Предыдущие обсуждения в Collision были более обнадеживающими. Бизнес-директор Google DeepMind Колин Мердок сказал в другом диалоге, что ИИ решает некоторые из самых сложных мировых проблем. На этом фронте особых споров нет — DeepMind каталогизирует все известные белки, борется с устойчивыми к антибиотикам бактериями и даже ускоряет работу над вакцинами против малярии. Он представил себе «искусственный общий интеллект», который мог бы решать множество проблем, и привел в качестве примера продукты Google. Lookout полезен для описания фотографий, но базовая технология также делает YouTube Shorts доступными для поиска. Мердок дошел до того, что назвал последние шесть-двенадцать месяцев «моментом лампочки» для ИИ, который раскрыл свой потенциал.

Главный научный сотрудник Roblox Морган Макгуайр во многом согласен. Он считает, что генеративные инструменты искусственного интеллекта игровой платформы «сократили разрыв» между новыми создателями и ветеранами, упростив написание кода и создание внутриигровых материалов. Roblox даже выпускает модель ИИ с открытым исходным кодом, StarCoder, которая, как они надеются, поможет другим, сделав большие языковые модели более доступными. Хотя Макгуайр в ходе обсуждения признал проблемы с масштабированием и модерированием контента, он считает, что метавселенная обладает «неограниченными» возможностями благодаря своему творческому пулу.

И Мердок, и Макгуайр выразили некоторые из тех же опасений, что и Хинтон, но их тон был явно менее паникерским. Мердок подчеркнул, что DeepMind хочет «безопасного, этичного и инклюзивного» ИИ, и указал на консультации экспертов и инвестиции в образование в качестве доказательства. Руководитель настаивает на том, что он открыт для регулирования, но только до тех пор, пока оно позволяет «потрясающие прорывы». В свою очередь, Макгуайр сказал, что Roblox всегда запускал генеративные инструменты искусственного интеллекта с модерацией контента, полагался на разнообразные наборы данных и практиковал прозрачность.

Какая-то надежда на будущее

Несмотря на заголовки, резюмирующие его недавние комментарии, общий энтузиазм Хинтона в отношении ИИ не уменьшился после ухода из Google. Если бы он не ушел, он был уверен, что будет работать над мультимодальными моделями ИИ, в которых зрение, язык и другие подсказки помогают принимать решения.

«Маленькие дети учатся не только на языке», — сказал он, предположив, что машины могут делать то же самое.

Как бы он ни был обеспокоен опасностями ИИ, он считает, что в конечном итоге он может делать все то же, что и человек, и уже демонстрировал «небольшие рассуждения». Например, GPT-4 может адаптироваться для решения более сложных головоломок.

Хинтон признает, что в его выступлении о столкновении мало что говорилось о хорошем использовании ИИ, например, для борьбы с изменением климата. Развитие технологии искусственного интеллекта, вероятно, было полезным, даже если по-прежнему важно беспокоиться о последствиях. И Хинтон открыто признал, что его энтузиазм не угас, несмотря на надвигающиеся этические и моральные проблемы.

«Я люблю ИИ», — сказал он. «Как можно не любить делать умные вещи?»

Подписывайтесь на T4S.TECH в Telegram. Публикуем новости, обзоры и забавные факты о технологиях.